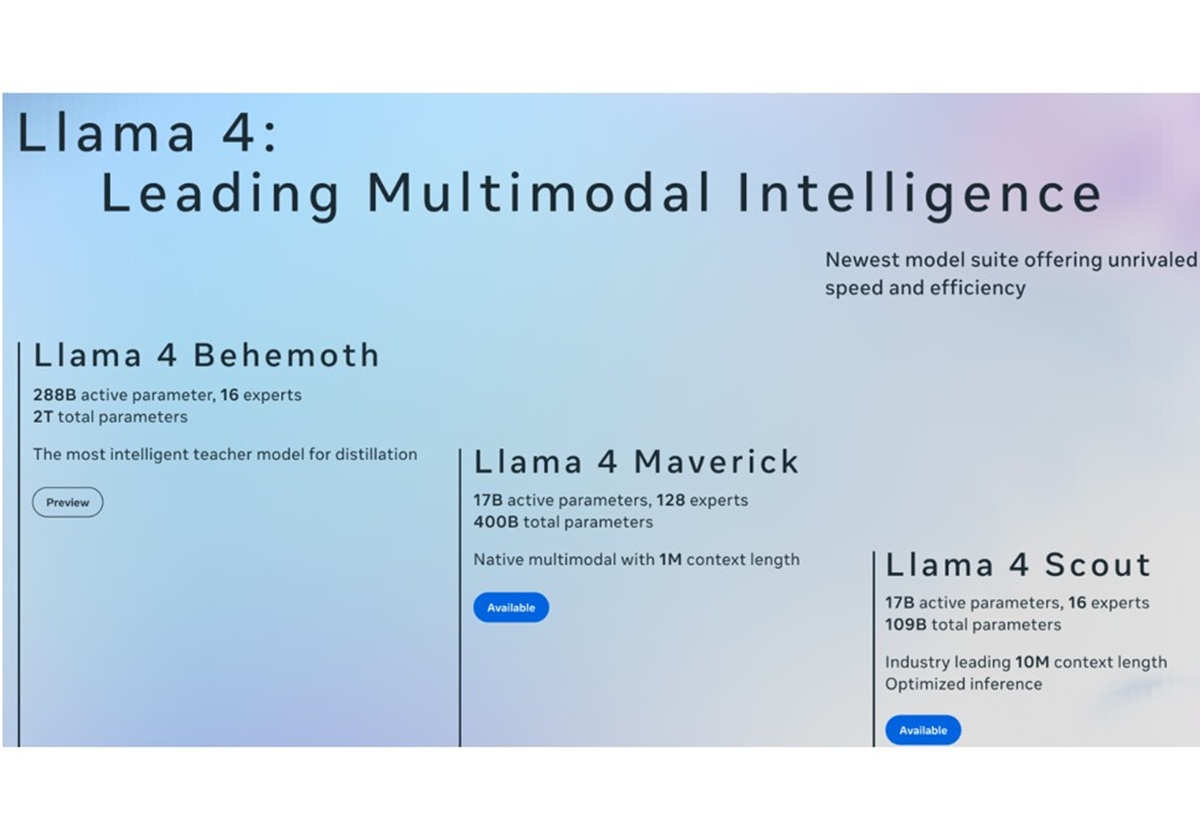

Meta「Llama 4」の卓越したスペックを活用しない手はない…AIモデルのゲームチェンジャー?

2025.05.23

ビジネスジャーナル

●この記事のポイント

・Meta「Llama 4」、モデル全体としては巨大なパラメータ数を維持しつつも、実際の計算時には必要な部分だけを効率的に活用

・業界最長の1,000万トークンに対応、従来の約78倍という圧倒的な差

・社内の膨大なドキュメントや過去の事例を学習させ、問い合わせ対応や資料作成、意思決定支援などに役立てることが想定

Meta社はAIモデル「Llama 4 Scout」「Llama 4 Maverick」をオープンモデルとして公開した。とはいえ、この手のニュースを見てもあまり驚かない人が多いだろう。AI技術の進化は目覚ましく、新しいモデルやサービスに関する情報が毎週のように発信され、AI関連のニュースはある種の「インフレ状態」とも言えるからだ。では、そのような状況で、今回のMeta社によるLlama 4の発表はいったい、どれほどのインパクトを持つのだろうか。

カスタムAI開発などを通じてクライアントの課題解決を行うLaboro.AIのリード機械学習エンジニア川崎氏に話を聞いた。従来のAIモデルと比較して、今回のLlama 4は具体的にどのような進化を遂げたのか。川崎氏によれば、その特徴は大きく3つあるという。

●目次

- まるで総合医から専門医集団へ。高度に洗練されたMoEアーキテクチャ

- 「本100冊分」相当の1000万トークンに対応、桁違いに圧倒的なコンテキスト長

- AIのトレンドをしっかり捉えたマルチモーダル能力の向上

- Llamaの進化は、オーバースペックか?ゲームチェンジャーか?

- Llama 4の可能性と課題

まるで総合医から専門医集団へ。高度に洗練されたMoEアーキテクチャ

1つ目に挙げたのは高性能なMoE(Mixture of Experts)だ。MoEとは、入力された情報に応じて、その処理に最適な「専門家」にあたるパラメータ群を選択的に使用する仕組みのこと。

「AIモデルは非常に多くのパラメータと呼ばれる要素を内部に抱えています。従来のAIモデルが文章を生成する際には、全てのパラメータを使用して計算する必要があります。高性能なAIモデルになればなるほど必要なパラメータ数が増えるため、計算コストは大きな課題となっていました。その点、Llama 4はモデル全体としては巨大なパラメータ数を維持しつつも、実際の計算時には必要な部分だけを効率的に活用できる。つまり、処理速度の向上や計算コストの削減が期待できます」と川崎氏は説明する。

どれくらい効率的なのか、私たちにとって身近な分野、例えば病院で例えるとわかりやすい。

「従来のAIが総合医のように全ての分野を一手に担当していたのに対し、Llama 4は脳神経外科や循環器内科といった専門医のように細分化された専門知識を持ち、必要に応じて最適な専門医を呼び出すことができるようになっています。リアルな人間社会でも専門分野が細分化されることで高度な対応ができるように、AIもまた、より効率的かつ高度な処理を目指して進化しているのです」

この考え方自体は2018年ごろから存在したが、ChatGPTが登場してから特に大きく発展し、GoogleのGeminiなどでも採用されていると言われている。しかし、Llama 4ではこのアプローチがさらに洗練されているという。

「本100冊分」相当の1000万トークンに対応、桁違いに圧倒的なコンテキスト長

「Llama 4のもう一つの大きな特徴は、扱えるコンテキストウィンドウが飛躍的に大きくなったことです」と川崎氏は強調する。

コンテキストウィンドウとは、AIが一度に理解・記憶できるテキストの量のこと。「作業メモリ」とイメージしてもいい。従来のOpenAIのモデルなどでは約12万8,000トークンが上限だったが、今回発表されたLlama 4 Scoutは、業界最長の1,000万トークンに対応する。これは従来の約78倍という圧倒的な差である。