Googleが来場者をざわつかせた「AIとの対話」

2024.05.21

東洋経済オンライン

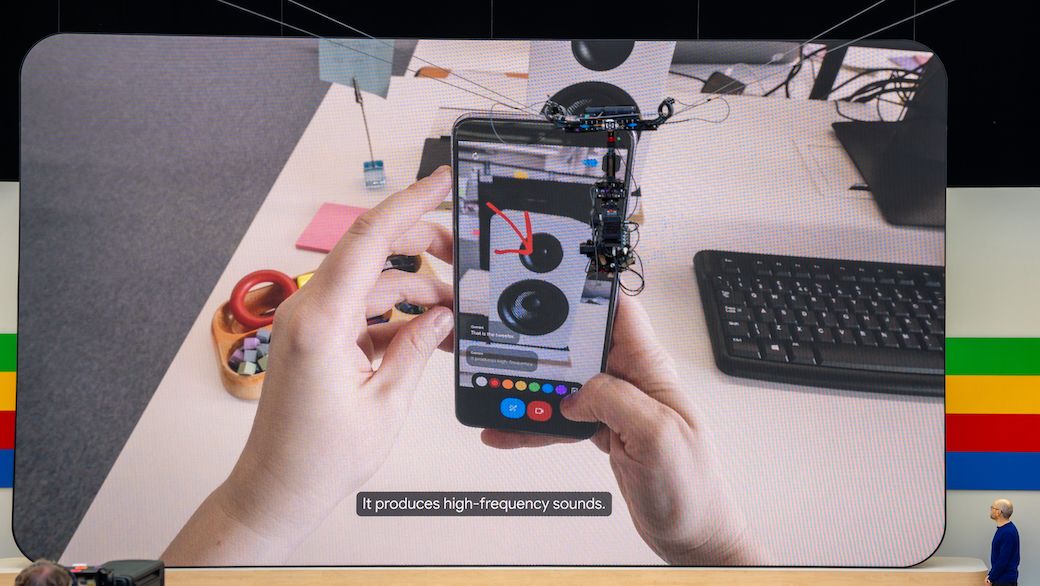

5月14日(アメリカ太平洋時間)に開催された「Google I/O」はAIにフォーカスした内容に(筆者撮影)

生成AIを軸とした、ビッグテックによる「AI開発競争」が第2幕を迎えた。

5月14日(アメリカ太平洋時間)にGoogleは、例年通り年次開発者会議「Google I/O 2024」を開催。今年は例年以上に「AI」にフォーカスした基調講演を行った。

一方でそれに先回りするように、5月13日にはOpenAIが同社の生成AI「GPT-4」の改良版にあたる「GPT-4o」を発表し、話題をさらった。

両社の発表には明確な共通点がある。

それは「画像・音声対応」と「即応性」だ。

こうした要素を両社が重視するのは、AIの活用が一般化するために必須のことだからである。

それはどういうことなのか、そして、この変化はスマートフォンなどにどのような変化をもたらすかを考えてみよう。

自然な対話を実現する「Project Astra」

Google I/Oでの発表の中でも、来場者が特にざわめいたのは「Project Astra」だった。

これがどのような技術であるかは、基調講演で公開されたデモのビデオを見るのが近道だ。

Project Astraデモ動画

スマートフォンのカメラで見たものがなにかを識別し、声での質問に、自然な音声で答える。ただ回答するだけではない。単に目の前の課題に答えるだけでなく、それまでに交わした会話の中で出てきたものを理解し、記憶し、その情報を使って質問に回答する。

Project Astraのデモ画面。カメラに映った内容に書き込みをしつつ音声で質問(筆者撮影)

Google I/Oの会場には限定的なものながら、デモを体験できる機会も用意されていた。筆者も体験してみたが、非常に印象的なものだった。

画面に線で絵を描き、「これはランドマークの1つ」とヒントを与えると、Astraは「ゴールデンゲートブリッジですね」と答える。

最初に黄色いバスのおもちゃを見せて「これはジョージという名前」と伝え、その後にいくつか別のおもちゃを見せつつ名前をつけたあと、「ジョージの色は?」と聞くと「黄色ですね」と答えてくる。

回答はスムーズで、人間との対話にかなり近い。知識を蓄えた生成AIや検索エンジンとも異なり、より人間のように多様な情報を使い、人間のような対話を実現するもの……という印象だ。

チャットボットから「マルチモーダル」へ

現在の生成AIは、命令を文章として与えて回答が文章で返ってくる「チャットボット型」のサービスが主流だ。しかし、それだけが生成AIの使い方というわけではない。

GoogleがProject Astraで目指すのは「将来のAIエージェント」だ。AIエージェントとは、人と対話しつつ人をサポートするソフトウェアのことだ。GoogleのAI開発部門「Google DeepMind」は、現在Googleが使っている生成AI技術である「Gemini」を応用しつつ、さらに新しい技術を組み込んで開発を進めている。

AIエージェントでは単に命令を音声で伝えるだけでなく、コミュニケーションが主体になって課題を解決することが重要になる。人間が目や耳から情報を得て、それを対話のために活用するのと同じように、AIエージェントも複数の情報を活用するのが望ましい。

こうした要素を俗に「マルチモーダル」と呼ぶ。GoogleはGeminiを「マルチモーダルが得意なAI」とアピールしてきた。Project Astraはその先にあるものだが、他にも広く活用している。

例えば、動画を撮影しながらそこに映っているものについて質問する「Ask with Video」や、写真を保存するサービスである「Googleフォト」の中から、文章で示したシチュエーションにあった写真を探し出す「Ask Photos」などの新機能がそれにあたる。